Daten gelten längst als das „Öl der Digitalisierung“ – sie treiben Innovationen an, optimieren Geschäftsprozesse und sind die Grundlage für intelligente Entscheidungen. Doch während Unternehmen früher mit Gigabyte oder Terabyte hantierten, explodieren die Datenmengen heute regelrecht: 2024 wurden weltweit rund 149 Zettabyte an Daten erzeugt, für 2025 werden bereits 181 ZB erwartet. Diese schiere Masse macht deutlich: Entscheidend ist nicht mehr nur das Sammeln von Informationen, sondern vor allem deren gezielte Analyse und Verwandlung in echten Geschäftswert. Wer es schafft, aus Rohdaten wertvolle Erkenntnisse zu gewinnen, verschafft sich einen klaren Wettbewerbsvorteil. In diesem Artikel erfährst Du alle wichtigen Fakten zur Datenerfassung und Datenanalyse.

Grundlagen – Was ist wichtig zu verstehen?

Datenerfassung: Wie Daten entstehen

Daten begleiten uns heute in nahezu jedem Lebens- und Geschäftsbereich. Sie entstehen an unzähligen Stellen: beim Einkauf über eine App, beim Klicken durch eine Website, beim Scannen von Waren im Lager oder durch Sensoren in Maschinen. Auch klassische Unternehmenssysteme wie ERP-Software, CRM-Lösungen oder Finanztools erzeugen täglich Millionen von Datensätzen. Hinzu kommen externe Quellen wie offene Datenplattformen oder Partnerdaten.

Damit Unternehmen diese Informationen nutzen können, müssen sie zunächst erfasst, gesammelt und zugänglich gemacht werden. Dabei spielen moderne Schnittstellen (APIs), Echtzeit-Streaming-Systeme oder automatisierte Importprozesse eine zentrale Rolle. Ohne eine solide Grundlage in der Datenerfassung bleiben die wertvollsten Informationen oft ungenutzt.

Datenanalyse: Vom Sammeln zur Erkenntnis

- Deskriptive Analysen: „Wie haben sich die Umsätze im letzten Quartal entwickelt?“

- Diagnostische Analysen: „Warum sind die Verkaufszahlen in Region X gesunken?“

- Prädiktive Analysen: „Welche Kunden werden wahrscheinlich abwandern?“

- Preskriptive Analysen: „Welche Maßnahme steigert die Kundenbindung am stärksten?“

Wichtige Begriffe einfach erklärt

Damit die Grundlagen verständlich bleiben, lohnt sich ein Blick auf die wichtigsten Begriffe:

- Data Lake

Ein Data Lake ist ein zentrales Speicherbecken für Rohdaten aller Art – ob strukturiert, halbstrukturiert oder unstrukturiert. Er ist flexibel, aber ohne klare Ordnung besteht die Gefahr, dass er zu einem „Data Swamp“ verkommt. - Data Warehouse

Im Gegensatz dazu ist ein Data Warehouse stark strukturiert. Daten werden nach festen Regeln aufbereitet, um Berichte, Dashboards und Business-Intelligence-Analysen zuverlässig zu unterstützen. - Data Mesh

Hierbei handelt es sich nicht um eine Technologie, sondern um ein organisatorisches Konzept. Anstatt Daten in einem zentralen Team zu bündeln, werden sie als „Produkte“ in den jeweiligen Fachbereichen verantwortet. Das fördert Eigenverantwortung und Skalierbarkeit, setzt aber klare Standards voraus. - Data Governance

Dieser Begriff beschreibt die Regeln, Prozesse und Verantwortlichkeiten, die für einen sicheren und verantwortungsvollen Umgang mit Daten sorgen. Governance stellt sicher, dass Daten korrekt, zugänglich, geschützt und gesetzeskonform verwendet werden.

Fazit zur Datenerfassung und Datenanalyse

Die Grundlagen der Datenerfassung und Datenanalyse sind mehr als nur technische Schlagworte. Sie bilden das Fundament, auf dem moderne Geschäftsmodelle, datengetriebene Entscheidungen und innovative Technologien wie Künstliche Intelligenz aufbauen. Wer versteht, wie Daten entstehen, wie sie sinnvoll analysiert werden können und welche Konzepte dabei eine Rolle spielen, schafft die Basis für nachhaltigen Geschäftserfolg.

Gefällt Dir, was Du liest? Dann Schau Dich auf unserer Seite um und Du wirst weitere spannende Themen finden.

Datenerfassung – Wo kommen die Daten her?

Die Grundlage jeder datengetriebenen Strategie ist die Datenerfassung. Nur wenn ein Unternehmen weiß, woher seine Informationen stammen und wie sie gesammelt werden können, lassen sich daraus verlässliche Analysen und konkrete Geschäftsvorteile ableiten. Dabei spielt nicht nur die Quelle der Daten eine Rolle, sondern auch die Methode, mit der sie erfasst und verarbeitet werden.

Quellen der Datenerfassung

- Unternehmenssysteme (ERP, CRM & Co.)

Klassische Geschäftsanwendungen wie ERP-Systeme (Enterprise Resource Planning) oder CRM-Lösungen (Customer Relationship Management) sind wahre Datenlieferanten. Sie enthalten zentrale Informationen über Bestellungen, Lagerbestände, Lieferketten, Kundenkontakte und Verkaufsprozesse. Für viele Firmen sind diese Systeme der Ausgangspunkt für Reporting, Controlling und Forecasting. - Nutzerinteraktionen (Web & Apps)

Jeder Klick auf einer Website, jede Suche in einem Onlineshop und jede Aktion in einer App hinterlässt Spuren. Diese Clickstreams sind wertvolle Hinweise darauf, wie Kunden Produkte nutzen, welche Inhalte sie ansprechen und an welcher Stelle sie abspringen. Solche Daten sind die Basis für Conversion-Optimierung, Personalisierung und gezielte Marketingkampagnen. - IoT & Sensoren

Mit dem Internet of Things (IoT) kommen täglich neue Datenquellen hinzu. Maschinen, Fahrzeuge, Wearables oder Smart-Home-Geräte senden kontinuierlich Sensordaten. In der Industrie helfen diese Informationen etwa beim Predictive Maintenance: Anhand von Vibrationen, Temperatur oder Auslastung lassen sich Ausfälle frühzeitig erkennen und vermeiden. - Externe Datenanbieter

Neben internen Quellen greifen Unternehmen zunehmend auf externe Daten zurück: Markt- und Wettbewerbsinformationen, demografische Daten, Wetterdaten oder Social-Media-Daten. Diese ergänzen das eigene Wissen und ermöglichen präzisere Analysen, etwa bei der Nachfrageprognose oder der Standortplanung.

Methoden der Datenerfassung

- Stapelweise Verarbeitung (Batch)

Beim klassischen Batch-Verfahren werden Daten gesammelt, zwischengespeichert und in festgelegten Intervallen – etwa täglich oder stündlich – verarbeitet. Diese Methode eignet sich für Szenarien, in denen Aktualität nicht im Vordergrund steht, z. B. beim monatlichen Finanzreport. - Echtzeit-Streaming

Immer wichtiger wird die Echtzeitverarbeitung von Daten. Mit Plattformen wie Apache Kafka oder Pulsar lassen sich Ereignisse sofort erfassen und weiterleiten. So können Systeme unmittelbar reagieren – etwa ein Betrugserkennungssystem bei einer verdächtigen Kreditkartentransaktion oder eine Empfehlungsmaschine, die direkt passende Produkte anzeigt. - Change Data Capture (CDC)

CDC ist eine Methode, mit der Änderungen in Datenbanken in Echtzeit erkannt und weitergegeben werden. Anstatt komplette Tabellen regelmäßig neu zu laden, werden nur die Veränderungen übertragen. Das spart Ressourcen und ermöglicht eine nahezu sofortige Synchronisation zwischen Systemen.

Trend: Echtzeitdaten als Erfolgsfaktore

Der wohl wichtigste Trend in der Datenerfassung ist die zunehmende Bedeutung von Echtzeitdaten. Kunden erwarten personalisierte Angebote im Moment der Interaktion – nicht erst Stunden später. Unternehmen wiederum wollen Risiken sofort erkennen, zum Beispiel bei Betrugsversuchen, Lieferengpässen oder Maschinenausfällen.

Während Batch-Verfahren nach wie vor sinnvoll sind, wenn es um große Datenmengen ohne Zeitdruck geht, entwickeln sich Streaming und CDC zu den Schlüsselelementen moderner Datenarchitekturen. Sie machen es möglich, Informationen nicht nur zu speichern, sondern in entscheidenden Momenten sofort nutzbar zu machen.

Daten speichern & organisieren

Die Datenerfassung ist nur der erste Schritt – mindestens genauso wichtig ist die Frage, wo und wie Daten gespeichert werden. Denn nur mit der richtigen Struktur lassen sich Informationen effizient nutzen, auswerten und für geschäftskritische Entscheidungen einsetzen. Unternehmen stehen dabei vor verschiedenen Architekturansätzen, die jeweils eigene Vor- und Nachteile haben.

Data Warehouse – für saubere, strukturierte Analysen

Ein Data Warehouse ist sozusagen das „Rechenzentrum“ der klassischen Datenanalyse. Hier werden Daten aus unterschiedlichen Quellen gesammelt, bereinigt, transformiert und in einem einheitlichen, strukturierten Format gespeichert.

- Typische Anwendungsfälle: Finanzberichte, Controlling, Dashboards für Managemententscheidungen

- Vorteile: hohe Datenqualität, schnelle Abfragen, klare Strukturen

- Nachteile: weniger flexibel für unstrukturierte oder schnell wechselnde Daten

Data Warehouses eignen sich besonders für Unternehmen, die verlässliche, standardisierte Reports benötigen und auf Konsistenz setzen. Bekannte Plattformen sind z. B. Snowflake, Amazon Redshift oder Google BigQuery.

Data Lake – für rohe, unstrukturierte Daten

Im Gegensatz dazu ist ein Data Lake deutlich flexibler. Hier können Rohdaten in jedem Format gespeichert werden – ob Tabellen, Bilder, Videos, Logfiles oder Sensordaten.

- Typische Anwendungsfälle: Big Data, Machine Learning, Data Science

- Vorteile: extrem skalierbar, kostengünstige Speicherung, hohe Flexibilität

- Nachteile: fehlende Ordnung kann schnell zu einem „Data Swamp“ führen, wenn keine Governance-Regeln existieren

Data Lakes sind das Rückgrat für moderne Analysen, die auch unstrukturierte Datenquellen wie Social-Media-Inhalte oder IoT-Sensoren einbeziehen.

Lakehouse – die Kombination der beiden Ansätze

Da Unternehmen häufig sowohl strukturierte als auch unstrukturierte Daten nutzen wollen, hat sich in den letzten Jahren das Lakehouse-Konzept etabliert. Es kombiniert die Flexibilität eines Data Lakes mit der strukturierten Organisation eines Data Warehouses.

- Vorteil: Ein einziger Speicherort für alle Datentypen

- Bietet sowohl BI-Reports als auch Data-Science-Workflows

- Beispiele: Databricks Delta Lake oder Apache Iceberg

Das Lakehouse gilt aktuell als ein zukunftsweisender Standard, weil es die Stärken beider Welten vereint.

Neue Konzepte: Data Mesh und Data Fabric

Data Mesh – Verantwortung in den Fachabteilungen

Traditionell liegen Daten oft in der Hand eines zentralen IT- oder BI-Teams. Das führt jedoch in wachsenden Unternehmen schnell zu Engpässen. Data Mesh verfolgt einen anderen Ansatz: Daten werden wie „Produkte“ behandelt und von den jeweiligen Fachabteilungen selbst verantwortet. Marketing, Vertrieb oder Produktion übernehmen die Verantwortung für ihre Datenprodukte – inklusive Qualität, Dokumentation und Zugänglichkeit.

- Vorteil: mehr Eigenverantwortung und Skalierbarkeit

- Herausforderung: erfordert starke Governance-Regeln und einheitliche Standards

Data Fabric – Vernetzung verschiedener Datenquellen

Während Data Mesh organisatorisch ansetzt, ist Data Fabric stärker ein technologisches Konzept. Ziel ist es, verschiedene Datenquellen – egal ob Cloud, On-Premise oder externe Systeme – nahtlos miteinander zu verknüpfen. Mit Hilfe von Metadaten, Automatisierung und KI sollen Daten leichter auffindbar, zugänglich und nutzbar werden.

Vorteil: holistische Sicht auf alle Datenbestände

Ideal für Unternehmen mit komplexen IT-Landschaften

Datenanalyse & KI

Die Erfassung und Speicherung von Daten sind nur die ersten Schritte. Der eigentliche Mehrwert entsteht erst dann, wenn Unternehmen ihre Daten systematisch auswerten und daraus konkrete Erkenntnisse ziehen. Datenanalyse ist dabei weit mehr als das Erstellen von Berichten – sie reicht von der einfachen Beschreibung vergangener Ereignisse bis hin zu komplexen Vorhersagen und Handlungsempfehlungen, die mit Hilfe von Künstlicher Intelligenz (KI) generiert werden.

Arten der Analyse

- Beschreibende Analyse („Was ist passiert?“)

Die beschreibende Analyse liefert einen Überblick über vergangene Ereignisse. Sie beantwortet Fragen wie: Wie viele Produkte wurden verkauft? Wie hoch war der Umsatz im letzten Quartal? Typische Instrumente sind Dashboards, Reports und Kennzahlen. Sie geben Führungskräften ein klares Bild der aktuellen Lage, sind jedoch rein rückblickend. - Vorausschauende Analyse („Was wird passieren?“)

Mit statistischen Modellen und Machine Learning lassen sich Prognosen für die Zukunft erstellen. Beispiele sind: Welche Kunden werden wahrscheinlich kündigen? Wie entwickelt sich die Nachfrage nach einem Produkt? Unternehmen nutzen diese Methoden, um Trends frühzeitig zu erkennen und Chancen oder Risiken gezielt anzugehen. - Handlungsempfehlende Analyse („Was sollten wir tun?“)

Die höchste Stufe ist die preskriptive Analyse. Sie liefert nicht nur Vorhersagen, sondern auch konkrete Empfehlungen für Maßnahmen. So kann ein System z. B. vorschlagen, bestimmte Marketingbudgets umzuschichten oder Wartungstermine für Maschinen vorzuziehen. Diese Analysen verbinden Vorhersagemodelle mit Optimierungsalgorithmen und eröffnen völlig neue Handlungsspielräume.

Machine Learning & KI im Einsatz

Die Nutzung von Künstlicher Intelligenz nimmt in Unternehmen rasant zu. Vor allem Machine Learning hilft dabei, Muster in großen Datenmengen zu erkennen, Vorhersagen zu treffen und Prozesse zu automatisieren. Klassische Anwendungsfelder sind:

- Betrugserkennung im Finanzwesen

- Predictive Maintenance in der Industrie

- Empfehlungssysteme im E-Commerce

- Nachfrageprognosen in der Logistik

Besonders im Fokus steht derzeit die Generative AI (GenAI). Sie ermöglicht nicht nur Analysen, sondern auch die Erzeugung neuer Inhalte – von Texten über Bilder bis hin zu Code. Unternehmen nutzen diese Technologie bereits für Chatbots, automatisierte Dokumentationen oder personalisierte Kundenkommunikation. Allerdings gilt: Ohne saubere, strukturierte und vertrauenswürdige Daten sind KI-Modelle wertlos. „Garbage in, garbage out“ – schlechte Daten führen zwangsläufig zu schlechten Ergebnissen.

Tools & Technologien

Damit Datenanalyse und KI im Alltag funktionieren, braucht es die richtigen Werkzeuge. Zu den wichtigsten zählen:

- dbt (Data Build Tool): Transformation von Daten in reproduzierbare, dokumentierte Modelle

- MLflow: Verwaltung und Nachverfolgung von Machine-Learning-Experimenten

- Airflow: Orchestrierung von Datenpipelines und Automatisierung von Prozessen

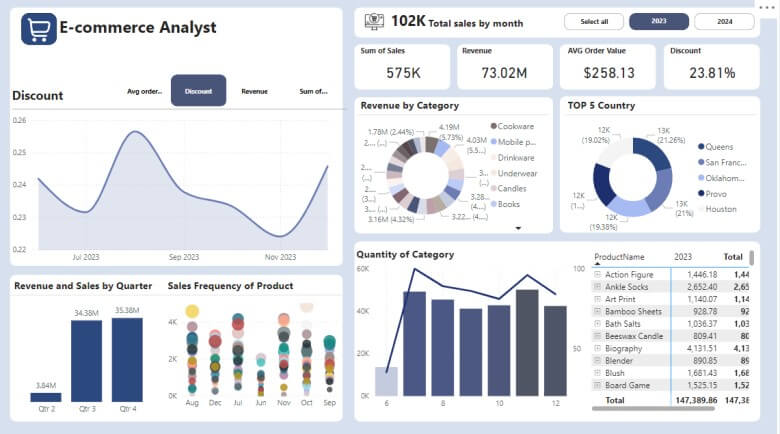

- BI-Tools (Business Intelligence) wie Power BI, Looker oder Tableau: Visualisierung von Daten, Dashboards und Self-Service-Analysen

Diese Tools bilden den Kern moderner Data & AI-Stacks und helfen, den gesamten Weg von Rohdaten über Analyse bis hin zu KI-Anwendungen abzudecken.

Trends 2025 – Daten, KI und neue Organisationsmodelle

Datenmengen explodieren weiter

Die Datenmengen steigen weiterhin rasant an. Während 2024 weltweit rund 149 Zettabyte an Daten erzeugt wurden, wird für 2025 ein Anstieg auf 181 Zettabyte prognostiziert. Diese Explosion betrifft nicht nur klassische Unternehmensdaten, sondern auch Sensorinformationen aus dem IoT, Social-Media-Daten, Logfiles und unstrukturierte Inhalte wie Texte, Videos und Bilder.

Die wachsende Datenflut stellt Unternehmen vor die Herausforderung, effiziente Speicher- und Analysearchitekturen zu entwickeln, um Informationen schnell nutzbar zu machen und echten Geschäftswert zu erzeugen.

Governance gewinnt an Bedeutung

Mit der steigenden Datenmenge steigt auch die Bedeutung von Datenqualität, Compliance und Governance. Immer mehr Unternehmen erkennen, dass ein systematischer Umgang mit Daten nicht optional, sondern geschäftskritisch ist.

- Datenqualität: Nur verlässliche Daten führen zu präzisen Analysen

- Compliance: DSGVO, CCPA und weitere Vorschriften verlangen klare Prozesse

- Verantwortlichkeiten: Rollen wie Data Owners oder Data Stewards werden in immer mehr Organisationen etabliert

Studien zeigen: Daten-Governance wird zunehmend als Top-Priorität eingestuft, weil sie die Grundlage für sichere, skalierbare und vertrauenswürdige Analysen bildet.

Echtzeitdaten & Streaming setzen sich durch

Ein weiterer zentraler Trend ist die Verlagerung von Batch- zu Echtzeitdaten. Unternehmen wollen Daten nicht erst stunden- oder tagelang speichern und verarbeiten, sondern sofortige Reaktionen ermöglichen.

- E-Commerce: personalisierte Empfehlungen in Echtzeit

- Finanzwesen: sofortige Betrugserkennung bei Transaktionen

- Produktion: Predictive Maintenance und Monitoring von Maschinen

Streaming-Plattformen wie Apache Kafka oder Pulsar gewinnen daher stark an Bedeutung. Wer Echtzeitdaten geschickt nutzt, kann schneller auf Marktveränderungen reagieren und Entscheidungen unmittelbarer treffen.

Generative AI verbreitet sich in vielen Unternehmensbereichen

Generative AI (GenAI) ist kein Zukunftsthema mehr – sie ist bereits in vielen Unternehmen angekommen. Von der automatisierten Textgenerierung über Chatbots bis hin zu grafischen Inhalten oder Codeproduktion: Die Einsatzmöglichkeiten wachsen rasant.

Wichtig dabei ist: Erfolg hängt von der Qualität der zugrunde liegenden Daten ab. Saubere, gut strukturierte und aktuelle Daten sind die Voraussetzung, damit KI-Modelle verlässliche Ergebnisse liefern. Unternehmen, die GenAI richtig einsetzen, können Prozesse automatisieren, Kreativität steigern und die Interaktion mit Kunden personalisieren.

Data Mesh & dezentrale Modelle verändern Organisationen

Mit zunehmender Datenkomplexität stoßen klassische zentrale Organisationsmodelle oft an ihre Grenzen. Data Mesh verfolgt einen neuen Ansatz: Daten werden als Produkte behandelt, die von den jeweiligen Fachabteilungen verwaltet werden.

- Vorteile: Skalierbarkeit, schnellere Verfügbarkeit von Daten, klare Verantwortung

- Herausforderung: Einheitliche Standards und Governance-Regeln sind notwendig

Parallel dazu ermöglicht Data Fabric, Datenquellen über verschiedene Systeme und Plattformen hinweg zu vernetzen. So entsteht ein ganzheitliches, zugängliches Datenökosystem, das Unternehmen flexibel und resilient macht.

Praxisbeispiele – Datenerfassung und Datenanalyse in der Realität

Um die Bedeutung von Datenanalyse und modernen Technologien greifbar zu machen, lohnt sich ein Blick auf konkrete Anwendungsfälle aus unterschiedlichen Branchen. Diese Beispiele zeigen, wie Unternehmen Daten gezielt nutzen, um Prozesse zu optimieren, Risiken zu minimieren und Kundenerlebnisse zu verbessern.

E-Commerce: Personalisierte Empfehlungen in Echtzeit

Im Online-Handel entscheiden oft Sekunden über den Erfolg einer Website. Personalisierte Empfehlungen sind ein Schlüssel, um Kunden zu binden und Umsätze zu steigern.

- Datenquelle: Klickverhalten, Warenkorbdaten, Suchanfragen, frühere Käufe

- Technologie: Echtzeit-Streaming, Machine Learning, Empfehlungsalgorithmen

- Nutzen: Kunden erhalten Produkte vorgeschlagen, die zu ihren Interessen passen, was die Wahrscheinlichkeit eines Kaufs deutlich erhöht

- Beispiel: Große Plattformen wie Amazon oder Zalando nutzen Echtzeitdaten, um Empfehlungen dynamisch anzupassen und personalisierte Angebote anzuzeigen

Dank solcher Systeme können Online-Shops Conversion Rates steigern, Abbrüche reduzieren und die Customer Experience individualisieren.

Produktion: Predictive Maintenance mit Sensordaten

In der Fertigungsindustrie kann ausfallbedingte Stillstandszeit teuer werden. Predictive Maintenance nutzt Sensordaten, um Maschinenprobleme vorherzusagen, bevor sie auftreten.

- Datenquelle: Vibrationen, Temperatur, Stromverbrauch, Produktionsgeschwindigkeit

- Technologie: IoT-Sensoren, Streaming-Daten, Machine Learning

- Nutzen: Früherkennung von Verschleiß oder Fehlfunktionen, Optimierung von Wartungsplänen, Reduzierung ungeplanter Ausfälle

- Beispiel: Automobilhersteller oder Maschinenbauer setzen Sensorik ein, um die Lebensdauer von Anlagen zu verlängern und Produktionsstillstände zu vermeiden

Unternehmen profitieren so von höherer Effizienz, geringeren Kosten und besserer Planungssicherheit.

Finanzen: Automatisierte Betrugserkennung

Im Finanzsektor ist Sicherheit zentral. Betrügerische Transaktionen müssen sofort erkannt werden, um Schaden zu verhindern.

- Datenquelle: Kontobewegungen, Transaktionshistorie, Standortdaten, Kundenprofile

- Technologie: Echtzeit-Streaming, KI-gestützte Mustererkennung, Anomalie-Detection-Modelle

- Nutzen: Verdächtige Transaktionen werden automatisch markiert oder blockiert, Risiko minimiert

- Beispiel: Banken und Zahlungsdienstleister wie PayPal oder Visa nutzen Machine Learning, um Betrugsversuche in Millisekunden zu erkennen und zu stoppen

So können Finanzunternehmen Vertrauen schaffen, Risiken reduzieren und regulatorische Anforderungen erfüllen.

Alles über Karriere und Erfolg

Hat dir der Artikel gefallen? Dann teil ihn bitte in deinen Netzwerken.